Quelques mots d’histoire

Ce que nous appelons intelligence artificielle générative – ou GenAI pour l’anglais generative artificial intelligence – est le fruit d’une longue histoire des technologies, de l’informatique et de la robotique. Le fantasme de créer des êtres artificiels dotés d’intelligence remonte, dans nos contrées, à l’ère antique. Golems, automates, robots et autres Frankenstein de tous poils sont quelques-uns des avatars de ce fantasme millénaire.

Pierre angulaire de l’histoire moderne de l’intelligence artificielle : la conférence de Dartmouth. En 1956, alors que l’informatique grand public est une vue de l’esprit, un groupe composé d’une quinzaine de chercheurs[1] en informatique et en psychologie se réunissent pendant deux mois pour travailler sur l’idée de machines capables d’imiter voire de surpasser l’intelligence humaine à l’aune des technologies émergentes de l’informatique. Le terme « intelligence artificielle » naît à ce moment-là pour fédérer chercheurs et financiers autour d’un concept accrocheur. En d’autres mots, la terminologie « intelligence artificielle » pour délimiter ce champ d’étude trouve son origine dans la nécessité de trouver un slogan accrocheur.

Aujourd’hui, certain·es chercheur·euses préfèrent utiliser le terme d’Informatique Avancée pour démystifier ce que nous nommons Intelligence Artificielle. Cet usage sémantique vise à éviter l’amalgame avec les intelligences humaines tout en accréditant le renouvellement d’une structuration numérique permise par les nouvelles avancées technologiques. L’émergence d’intelligences synthétiques capables de conscience et de sensibilité est un horizon souhaité par certain·es, terriblement craint par d’autres, qui occupe régulièrement l’espace médiatique. Mais, en l’état des recherches sur le sujet, cette hypothèse relève de la science-fiction.

Derrière l’usage du terme « intelligence », le vocabulaire de ces programmes est truffé de termes qui renvoient au vivant : apprentissage, neurones, langage… De la même manière que le stockage informatique de données disponibles via Internet dans des serveurs gigantesques et énergivores est nommé le « Cloud » (le nuage), le champ lexical en lien avec les IA est orienté vers des formes d’anthropomorphisation.

C’est un leurre : les créations générées par IA sont avant tout le résultat de générations probabilistes extraordinairement poussées à partir d’un traitement sophistiqué de milliards de données textuelles et imagées, transformées en chiffres.

Qu’est-ce qui se cache derrière le concept d’intelligence artificielle générative ?

Les GenIA sont des programmes informatiques complexes qui sont en mesure de générer du contenu à partir d’un prompt. Il existe deux grands types d’IA génératives grand public : les génératives de textes et les génératives d’images.

Du point de vue des utilisateur·rices, la génération d’une image fonctionne par la réponse d’une machine à la rédaction d’un prompt grâce à un programme dédié à la génération d’images choisi par l’utilisateur·rice. Pour générer des images, les logiciels d’IA génératives doivent avoir accès à une base de données gigantesque d’images entraînées et d’algorithmes sophistiqués qui permettent la transformation d’un texte en image en passant par du code chiffré. Les paragraphes qui suivent précisent chacun des termes évoqués ci-dessus.

Qu’est-ce qu’un « prompt » ?

Un prompt est une suite de caractères soumis à un logiciel d’IA pour générer du texte, des images, des vidéos ou tout autre type de contenus. Quand on tape sur « enter », une première opération déterminante a lieu : la traduction du prompt en langue anglaise. En effet, les logiciels popularisés chez nous ont été développés par des entreprises nord-américaines : elles ne fonctionnent que sur base de commandes et « d’étiquettes » (voir plus loin) en anglais. Déjà peuvent se nicher, à cette étape du processus, une série de biais culturels ou d’erreurs de traduction.

La « traduction » se poursuit : ces caractères se transforment en chiffres afin de générer de nouvelles suites de chiffres qui seront à leur tour traduites en texte ou en image pour fournir une réponse à l’utilisateur·rice.

En d’autres termes : le prompt correspond à la requête effectuée par un·e utilisateur·rice (qui peut-être une machine) pour générer du contenu après une transformation chiffrée.

(chat éponge), généré sur Grok

Qu’est-ce qu’un LLM ?

Un grand modèle linguistique (Large Language Model – LLM – en anglais) est un type de modèle d’IA générative entraîné sur de gigantesques ensembles de données textuelles pour produire du texte. En d’autres termes, ce sont des programmes informatiques nourris de milliards d’exemples textuels. Ce qui permet à la machine de reconnaître le langage humain. Ces programmes sont alimentés par les données disponibles sur Internet. Penser aux GenIA textuelles nous renvoie spontanément vers ChatGPT, Grok et autres Gemini. Mais les LLM sont aussi utilisés dans les moteurs de recherche en ligne, sont au cœur de chatbots, sont exploités pour des usages très précis comme des recherches scientifiques autour de l’ADN, ou encore pour des expériences en reconnaissance de sentiments. L’entraînement de ces modèles requiert des dispositifs techniques très puissants et énergivores, nécessitant l’utilisation de cartes graphiques puissantes.

LesIA génératives d’images ont des fonctionnements proches des LLM (entraînement des données, récolte de données imagées en ligne, modèle de fonctionnement gourmand en énergie) mais pour des résultats imagés plutôt que textuels.

L’un des moments clés dans l’histoire de la génération d’image est la création par OpenAI – société à l’origine de ChatGPT et Dall-E – du processus CLIP, le Contrasting Language Image Pre-training. CLIP est un modèle qui a la capacité de générer des étiquettes à partir d’une image qui lui est soumise. C’est donc un modèle de type automatisé qui a permis de créer, à une vitesse record, la source de données – binôme image et texte – nécessaire pour générer des images.

Qu’est-ce qu’un « data set » d’images ?

L’un des éléments centraux de la génération d’images est la constitution de bases de données gigantesques (les « data sets »). Ces bases de données rassemblent plusieurs milliards d’images entraînées pour réagir aux prompts rédigés par les utilisateur·rices – les inputs – et générer des images – les outputs.

La source des bases de données est principalement la masse d’informations disponible sur Internet. Cette réalité pose un important problème légal. Car les images qui alimentent les bases de données sont purement et simplement capturées sans la moindre demande de consentement des ayants droits et des personnes dont l’image est utilisée. En termes légaux, c’est globalement un vol à très grande échelle. Des ayant-droits ont déjà fait part de leur mécontentement face à cette situation ; d’autres comme la plateforme Getty Image sont partis en procès contre des opérateurs comme Stable Diffusion et Midjourney pour faire valoir leurs droits. De l’aveu même des opérateurs à l’origine des programmes d’IAG, accumuler les bases de données nécessaires au fonctionnement fluide de ces outils aurait été impayable. Des milliards d’euros sont évoqués.

Le choix des structures à l’origine du développement des IA génératives a donc été d’imposer cette technologie au grand public en faisant fi du droit. Aujourd’hui, certains opérateurs achètent des réseaux sociaux – Elon Musk et X, ex Twitter, par exemple – ou tissent des accords avec d’autres pour disposer d’un accès à leurs bases de données, qui alimenteront les leurs (Grok, dans le cas de Musk).

Après plusieurs années de génération d’images, Internet se retrouve progressivement inondé d’images générées par logiciels d’IA génératives. La corrélation directe est leur présence croissante au sein des bases de données des logiciels d’IA.

Qu’est-ce que « l’étiquetage » des images ?

Pour que le programme soit en mesure de transformer ces prompts en images, il faut d’abord qu’aient été « étiquetées » les données (rassemblées dans le « data set »). Les étiquettes, ce sont des mots attribués aux images dans leur ensemble ainsi qu’aux parties qui la composent. Le travail d’étiquetage est central dans l’entraînement des bases de données car c’est par ce travail que le logiciel est en mesure de reconnaître l’agencement de pixels en formes, en couleurs, en mouvements, en texture, en matière… L’efficacité et la justesse de la génération d’images dépend en grande partie de la qualité de l’étiquetage.

(chat réaliste – texture d’éponge), généré sur Dall-e / Open AI

La machine est en mesure de plus ou moins bien générer un « chat éponge » grâce aux millions d’images de chat et d’éponge qui ont auparavant été catégorisées (étiquetées) comme « chat » et « éponge ». Si chaque image de chat avait été étiquetée sous le nom « rhododendron », nous devrions rédiger le prompt « rhododendron » pour que le logiciel génère une image de ce que nous reconnaissons comme un chat[2]. La création de corrélation entre des étiquettes et des images est ce que nous appelons « l’entraînement ».

(Chat éponge courant dans un champs de fleurs), généré sur Stable Diffusion

Qui est responsable de l’étiquetage des données ?

Dans les premiers temps de l’entraînement des modèles, ce sont des personnes humaines qui se sont chargées manuellement de catégoriser chacune des images afin que le logiciel les reconnaisse. Aujourd’hui, l’étiquetage est plus ou moins automatisé en fonction des usages. Voici quelques méthodes d’étiquetage :

- L’annotation manuelle : celle qui requiert la présence humaine. Elle est aujourd’hui privilégiée pour la création d’IAG qui nécessitent des étiquettes les plus précises possible. Pour une IA médicale par exemple, l’annotation humaine est nécessaire. Vu le caractère sensible de ce type de données, l’étiquetage humain est validé par d’autres annotateur·rices expérimenté·es afin d’assurer un traitement rigoureux des données. Les IA génératives grand public n’entrent pas dans cette catégorie.

- L’annotation assistée par l’IA : des modèles d’IA sont pré-entraînés pour étiqueter des images via des boites englobantes, des classifications et/ou des masques de segmentation (voire le texte concernant les zones d’étiquetage). Des personnes vérifient ensuite les annotations effectuées par l’IA, les adaptent quand c’est nécessaire et alimentent ainsi les bases de données.

- Enfin, des processus totalement automatisés sont aujourd’hui à l’œuvre. Les données sont soumises à l’étiquetage d’un modèle d’IA pré-entraîné sur d’immenses ensembles de bases de données afin de produire un étiquetage sans intervention humaine. Ces modèles sont réputés efficaces sur des données standards dans des contextes communs. L’un des résultats de ce type de modèles est de favoriser le renforcement des standards – autrement dits, des clichés et stéréotypes – vu que la base de données d’images s’autoalimente à partir des mêmes données. Le programme sera également plus à même de générer des contenus farfelus. Dans un langage de type anthropomorphisant, on parle alors d’hallucinations de la machine. Enfin, c’est un processus très gourmand en termes informatiques et qui est donc énergivore.

Comment fonctionne l’étiquetage des images ?

Les images sont étiquetées en fonction d’un découpage de l’image en zones. Les zones sont de plusieurs ordres et créent des qualités de précisions diverses :

- La classification d’images correspond à la méthode la plus simple et la moins précise. L’annotateur·rice – informatique ou humain·e selon que la méthode utilisée soit automatique ou manuelle – annote l’intégralité de l’image avec une ou plusieurs étiquettes.

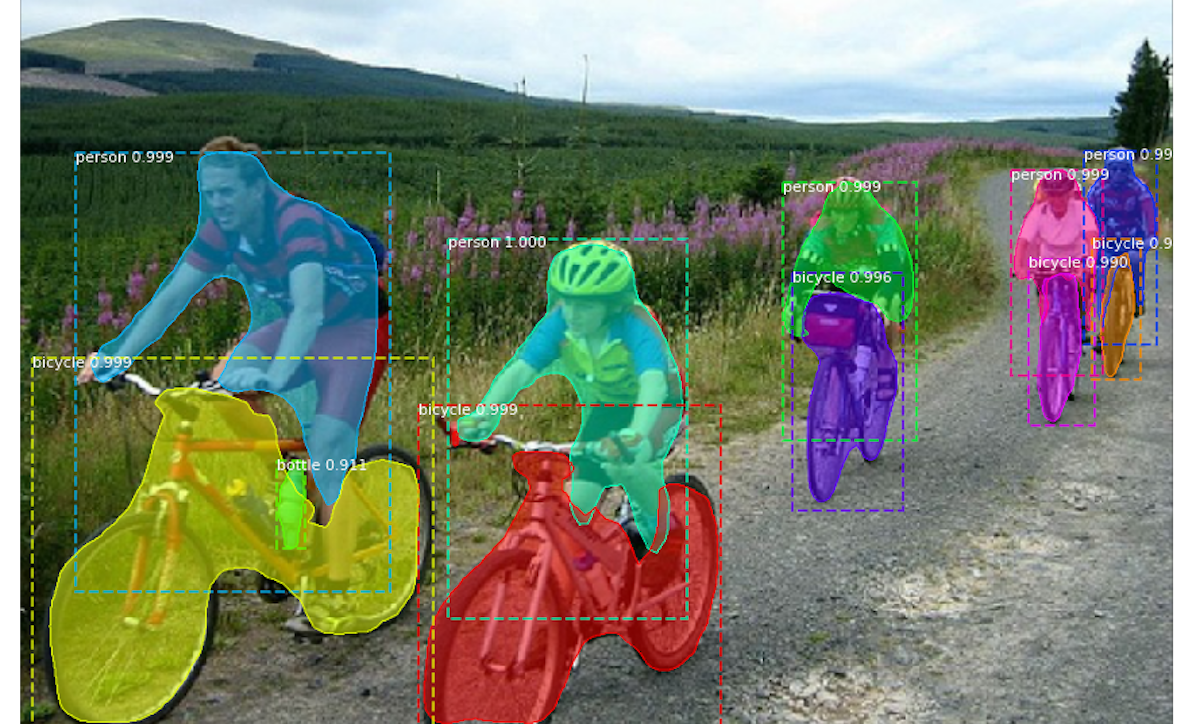

- La détection d’objets est un système par lequel l’annotateur·rice crée des boites rectangulaires qui entourent des objets et leur attribue une ou plusieurs étiquettes.

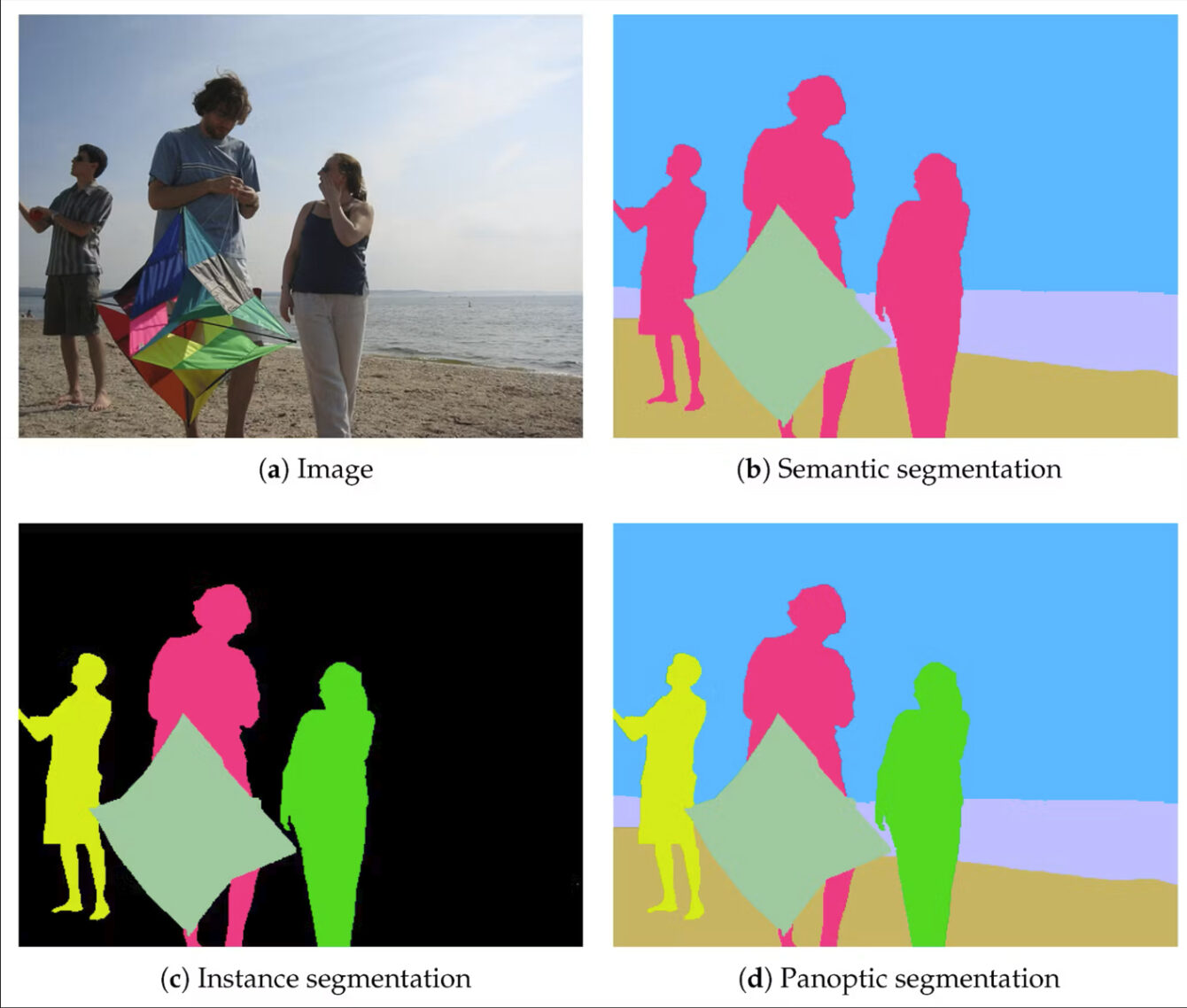

- La segmentation d’instances permet de créer des contours précis aux objets détectés. Alors que la boîte de la détection d’objets est un rectangle qui englobe également des éléments parasites, la création de contours précis évite les parasites en englobant exclusivement le contenu concerné par les étiquettes.

- La segmentation sémantique est un procédé plus complexe et plus complet qui consiste en une application de masques sur l’image qui apportent des couches sémantiques dans l’analyse de l’image. En plus de sélectionner les éléments à analyser, les couches sémantiques permettent au logiciel d’enregistrer les relations spatiales ainsi que les propriétés des matériaux dans des environnements complexes.

Quel est le rôle de ces étiquettes dans la génération d’images ?

Ces différentes méthodes permettent de créer des binômes texte/image plus ou moins complexes et pertinents qui alimentent les bases de données. Les images des bases de données sont accompagnées de textes – les étiquettes – qui permettent aux logiciels de trouver les images utiles à la génération d’une réponse – un output – pertinent en fonction du prompt – l’input – de l’utilisateur·rice. De manière logique, une IAG sera donc incapable de produire l’image de quelque chose qui n’a pas été étiqueté comme tel dans sa base de données (et improvisera un output).

Techniquement, comment le programme génère-t-il des images au départ d’un prompt ?

Le processus de génération d’image utilise un algorithme – une boucle – que l’on nomme Diffusion. Le fonctionnement technique est le suivant :

- Le processus démarre par une image composée exclusivement de bruit. Cette « image » est un tas de pixels aléatoire sans structure ni signification. On peut imaginer ce point de départ comme une version numérique du brouillard de l’écran de télévision.

- À partir de ce bruit, l’algorithme fait surgir l’image que nous lui avons commandée à partir du prompt. C’est un processus qui fonctionne par étape.

- À chacune des étapes :

- L’algorithme réduit le bruit en réponse au prompt. Lors de la première étape, le logiciel va puiser des images qui correspondent au prompt et va faire émerger une image avec encore 90 % de bruit.

- À chaque étape, le logiciel va confronter l’image obtenue à sa base de données constituée lors de l’entraînement pour évaluer si ce qui est lisible correspond au prompt rédigé.

- En parallèle, le logiciel génère une image avec la même quantité de bruit mais sans se baser sur le prompt. Le logiciel compare alors les deux images obtenues (celle générée avec et l’autre sans prompt), détecte les différences entre elles et renforce les particularités de l’image dotée d’un prompt.

- Le programme redémarre ensuite le processus en réduisant la quantité de bruit sur l’image obtenue pour arriver à une image qui ne contient plus de bruit.

Ce processus est nommé « diffusion de type arrière » : le point de départ est le bruit, le point d’arrivée est une image. Le programme doit avoir expérimenté au préalable le fonctionnement inverse à savoir la « diffusion avant » pour réaliser une « diffusion arrière ». Le point de départ de la « diffusion avant » est l’image, le point d’arrivée, le bruit. Les générateurs d’images actuels utilisent tous des modèles de Diffusion avec des variantes qui leurs sont propres.

On le constate : le fonctionnement des IA génératives est complexe, et vulgariser leur fonctionnement est épineux. Mais s’y essayer permet de dévoiler la dimension « probabiliste » du processus. Partant d’un agglomérat de pixels, jouant de comparaison avec des images exploitées comme ressources, le logiciel choisit à chaque étape ce qui lui semble correspondre à la meilleure association d’un mot du prompt avec un résultat visuel.

Quel programme utiliser ? Comment choisir ?

Les outils de génération d’image les plus populaires tels que Midjourney, Dall-E – le générateur d’images d’Open AI inclus dans ChatGPT –, Crayion ou Grok ont plusieurs caractéristiques communes :

- Ils sont disponibles en ligne.

- Ils imposent à l’utilisateur·rice de se connecter à leur plateforme « mère » (Google par exemple) pour avoir accès aux services.

- Ils proposent des abonnements payants pour bénéficier de l’intégralité des services.

- Ils fonctionnent uniquement à partir de prompts.

- Ils sont, pour la plupart, particulièrement puissants, efficaces, et faciles d’accès.

Ces solutions « clé sur porte » ont évidemment des zones d’ombre :

- Récupération des données des utilisateur·ices qui utilisent ces logiciels.

- Opacité de leur fonctionnement.

- Impact environnemental : ces solutions en ligne sont particulièrement énergivores, car les logiciels font fonctionner leurs infrastructures décentralisées pour générer la réponse à la requête.

En quelque mots : ces programmes en ligne, populaires et faciles d’usage, sont autant de boites noires qui récupèrent un maximum de données des utilisateur·rices pour alimenter leurs bases de données et leur modèle économique.

Ces outils numériques fonctionnent en osmose avec le reste de l’environnement numérique, les incontournables outils numériques en ligne dont le modèle est l’extraction et l’exploitation des données des utilisateur·ices (en très bref : les GAFAM[3]). Par le contrôle, la concentration et l’usage mercantile des données, ces outils sont, structurellement, des menaces pour nos modèles démocratiques. OpenAi, Grok et les autres fournisseurs d’outils d’IA suivent ce même chemin.

Une vigilance vis-à-vis de ces programmes s’impose, et ce malgré les tentatives de régulation de l’espace numérique européen par les institutions européennes…

Notons qu’il existe des réponses étatiques et associatives pour créer d’autres modèles d’IA génératives. Quelques options « open source » se distinguent favorablement du microcosme présenté ci-avant, comme Stable Diffusion, projet imaginé pour, justement, fonctionner en dehors de l’espace commercial.

Peut-on « prendre la main » sur le processus de création d’une image par IA générative ?

Comme souvent dans le registre informatique, pour s’éloigner des solutions proposées par les géants du Web, il faut un peu de temps et d’énergie. Ces solutions « open source » ont l’avantage de permettre à l’utilisateur·rice d’avoir (dans une certaine mesure) la main sur le processus de génération des images.

En mettant à disposition leur code source, elles ont permis le développement de solutions disponibles en téléchargement (afin d’avoir le logiciel sur son ordinateur, et pas en ligne) qui permettent « d’ouvrir la boîte noire » de la génération d’images. À contrepied de la majorité des autres générateurs d’images, un logiciel open source comme Stable Diffusion donne l’accès à de nombreux paramètres au moment de générer une image :

- La possibilité d’orienter la génération d’images en choisissant un modèle. Un modèle est une base de données réduite. Ce choix permet d’orienter l’esthétique de l’image obtenue mais aussi d’en orienter les résultats en matière de représentation par exemple.

- La possibilité de choisir le nombre d’étapes informatiques de génération d’une image, ce qui permet de visualiser concrètement les étapes effectuées par la machine lorsqu’elle affine l’image depuis le « bruit », et de choisir le moment où l’on « arrête » le processus de génération parce que le résultat correspond mieux à ce que l’on cherche.

- La possibilité de pondérer le degré de fidélité au prompt.

L’IA génératives : outil de création assistée et poste d’observation des normes

En rendant leur processus « génératif » invisible, les IA génératives masquent la complexe mécanique algorithmique qui est à l’œuvre : elle n’a rien d’intelligent, ou de magique. Ces logiciels « produisent » une traduction visuelle par l’entremise algorithmique, et ne « créent » pas. Ce geste créateur, pour qui utilise l’IA, se bornera probablement à « challenger » le mécanisme pour obtenir un résultat satisfaisant. Si l’on peut considérer les images produites comme fiables, c’est peut-être avant tout pour leur capacité à synthétiser les normes sociales. Malgré elles, les IA génératives facilitent finalement une éducation critique à l’Histoire de nos représentations.

Nicolas Bras (pour le CFA – Centre de Formation d’Animateurs)

[1] Dans l’histoire de l’inormatique, le travail des chercheuses et techniciennes a été largement invisibilisé. La conférence de Dartmouth n’a, ainsi, rassemblé que des hommes. Le choix d’écrire ici « chercheur » sans emploi de l’écriture inclusive rend donc état de cette discrimination.

[2] Notons déjà plusieurs éléments sur base de cet essai inoffensif. Aucune image générée n’a emprunté la texture de l’éponge marine. C’est uniquement des éponges de vaisselles qui ont été sollicitées dans la génération d’image. Aussi, traduire le prompt français « chat éponge » en « spongecat », mène certains logiciels à générer des « Bob l’éponge » du dessiné éponyme vaguement « félinisés » (la série se nomme Sponge Bob Square Pants en anglais).

[3] Acronyme de Google, Apple, Facebook, Amazon et Microsoft. Il devrait, en regard des « rebranding » résents, être modifié en AAMAM (Alfabet, Apple, Meta, Amazon et Microsoft).